使用DeepSeek API¶

约 1680 个字 3 行代码 25 张图片 预计阅读时间 6 分钟

先来说明一下为什么需要API,或者说有了网页版对话,为什么还需要申请API?

答:API允许开发者将服务集成到自己的应用中,提供更多的灵活性和定制选项,而网页版则是现成的产品,用户可以直接使用。

体验大模型¶

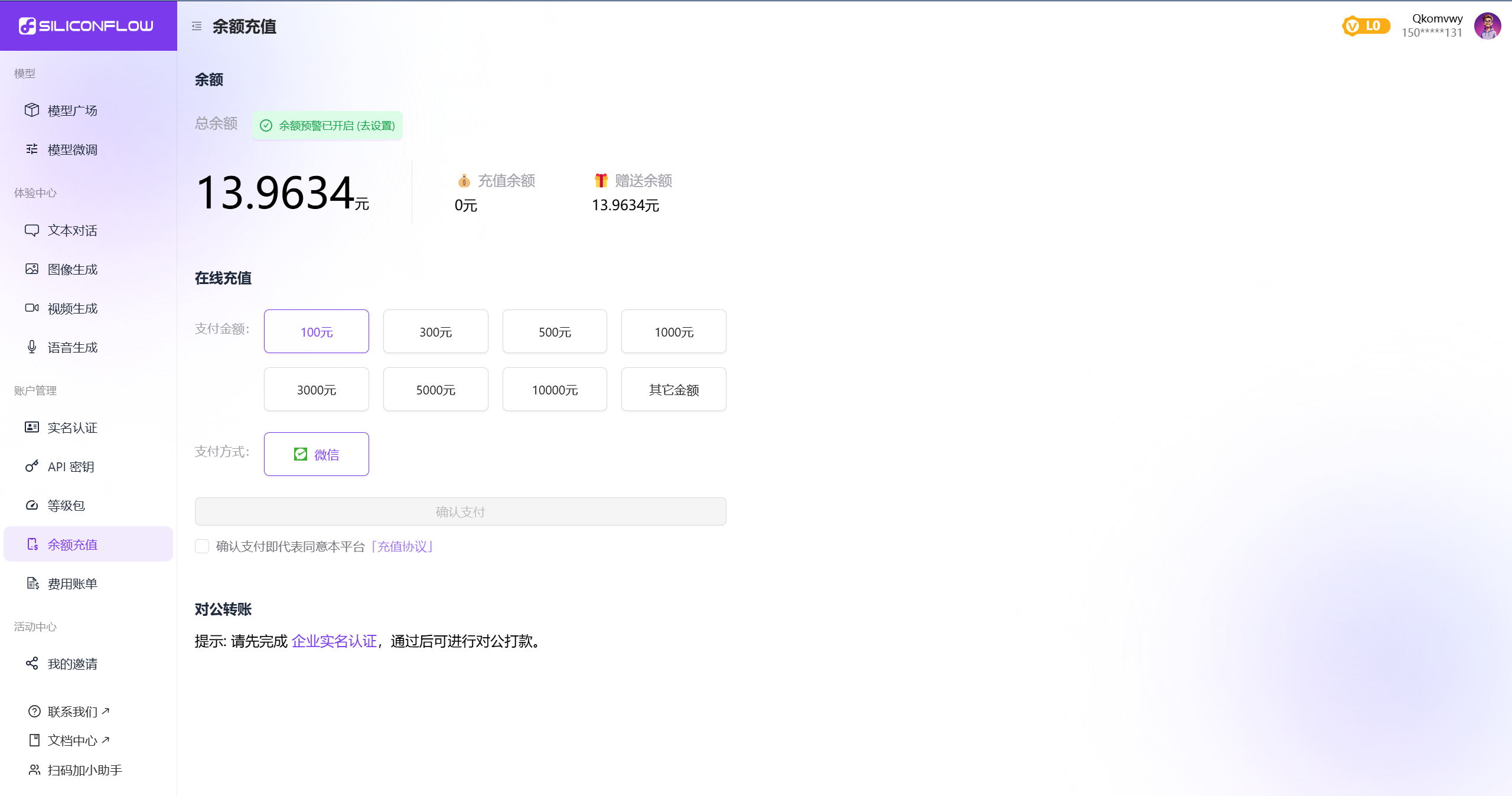

本次以硅基流动提供的DeepSeek API为参考,官网:https://siliconflow.cn/zh-cn ,直接使用手机号进行注册进行,邀请码选填,填写木木的邀请码的话可以增加更多的Tokens,感谢支持!木木的邀请码是:3tdvbvxC。

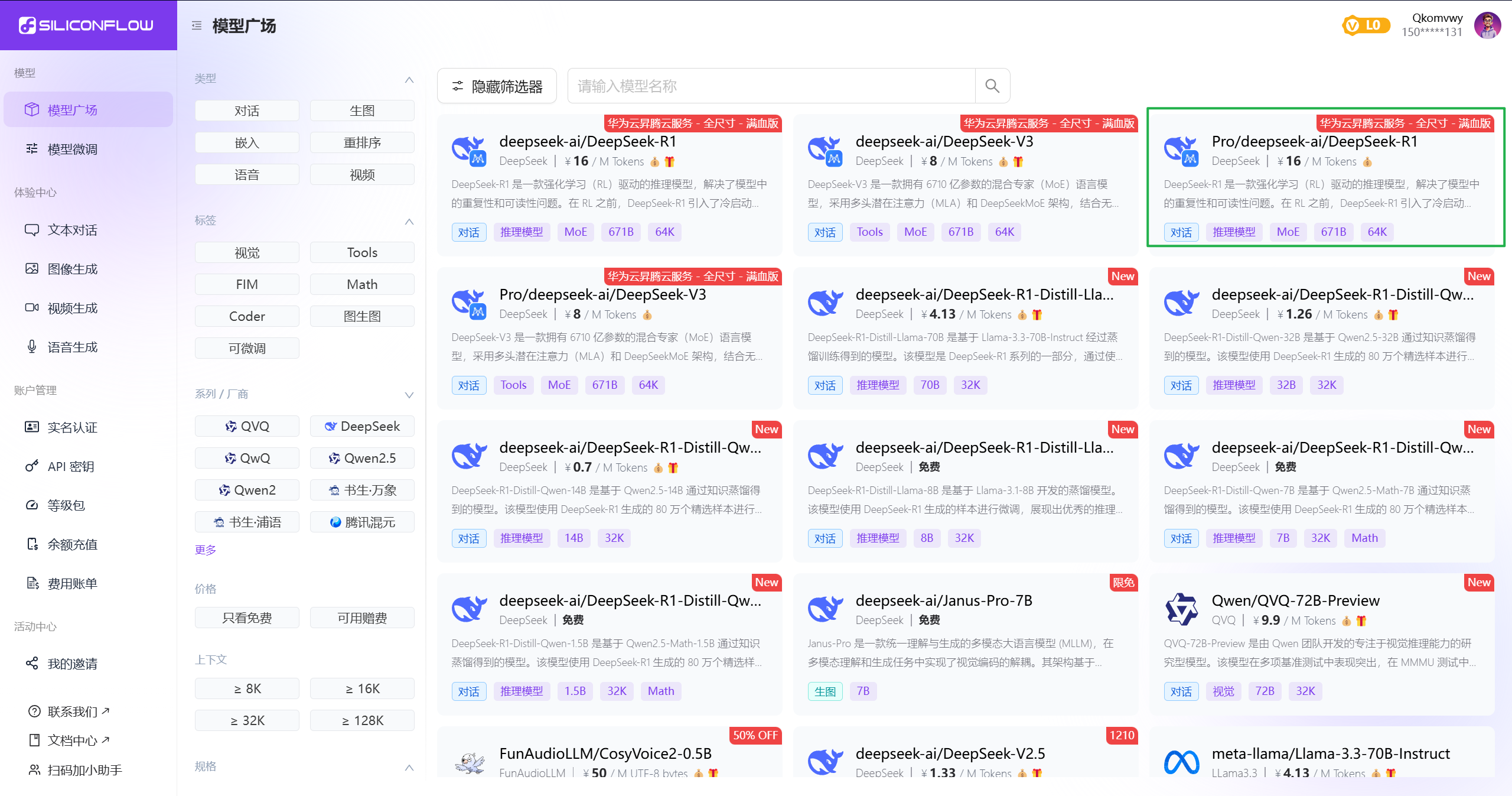

进入模型广场后,可以看到许多DeepSeek的大模型,正可谓“乱花渐入迷人眼”。

选择感兴趣的大模型即可在线体验。

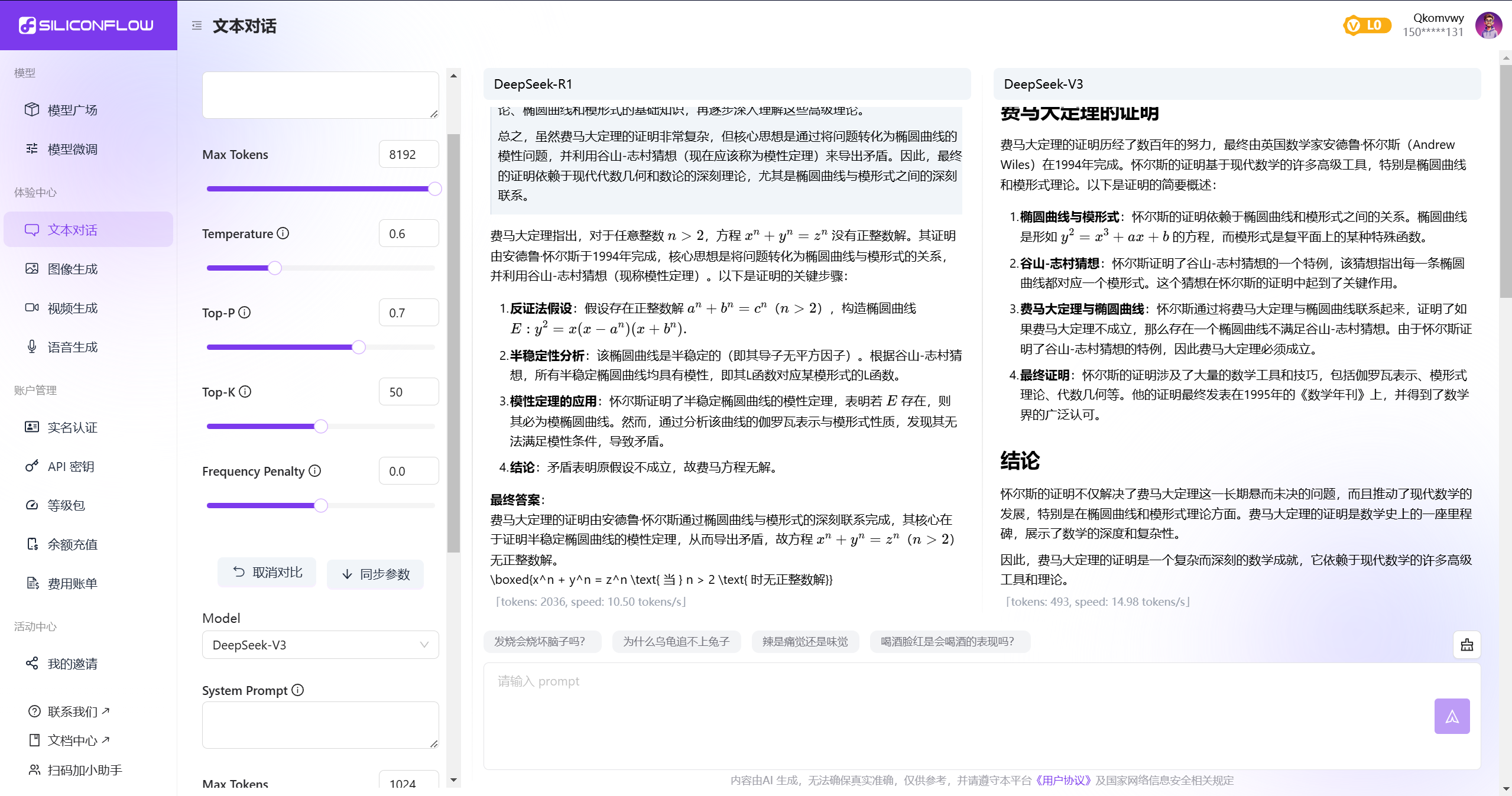

以R1和V3为例,对比两者消耗的Tokens。

从图中可以看出R1消耗的Tokens更多,同时给出的答案更加细致,推理模型的与以往的大模型有些许不同,本着思考的角度去解决问题,所以在实际体验时,生成过程比V3要慢一些。更多测试可以根据自己感兴趣的问题进行问答。

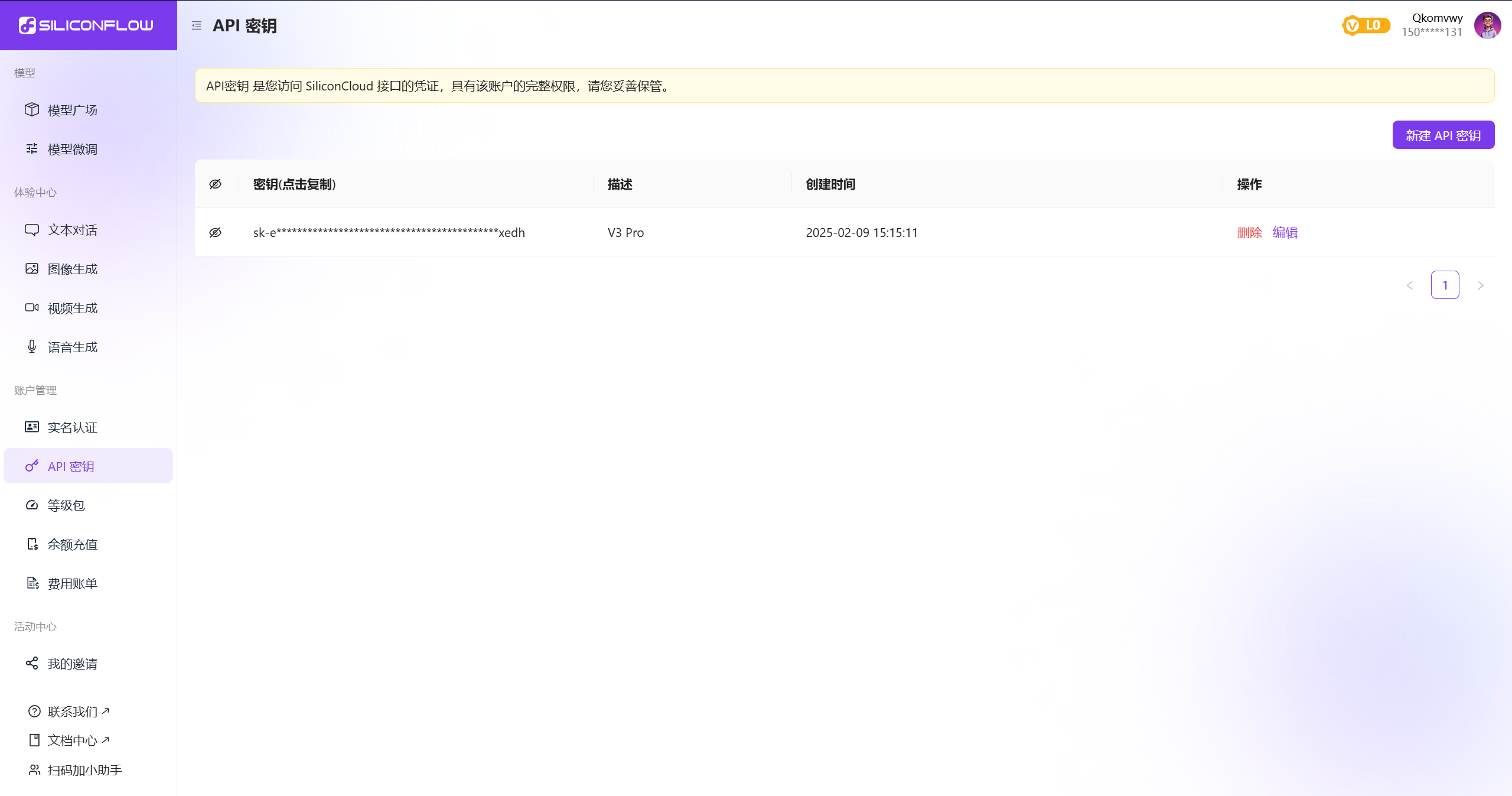

申请API¶

点击左侧菜单栏:API密钥,进行申请即可。描述信息可填写自己想要用于哪种类型,可不填。申请完毕后,鼠标悬停密钥,即可复制,一定要保存好!

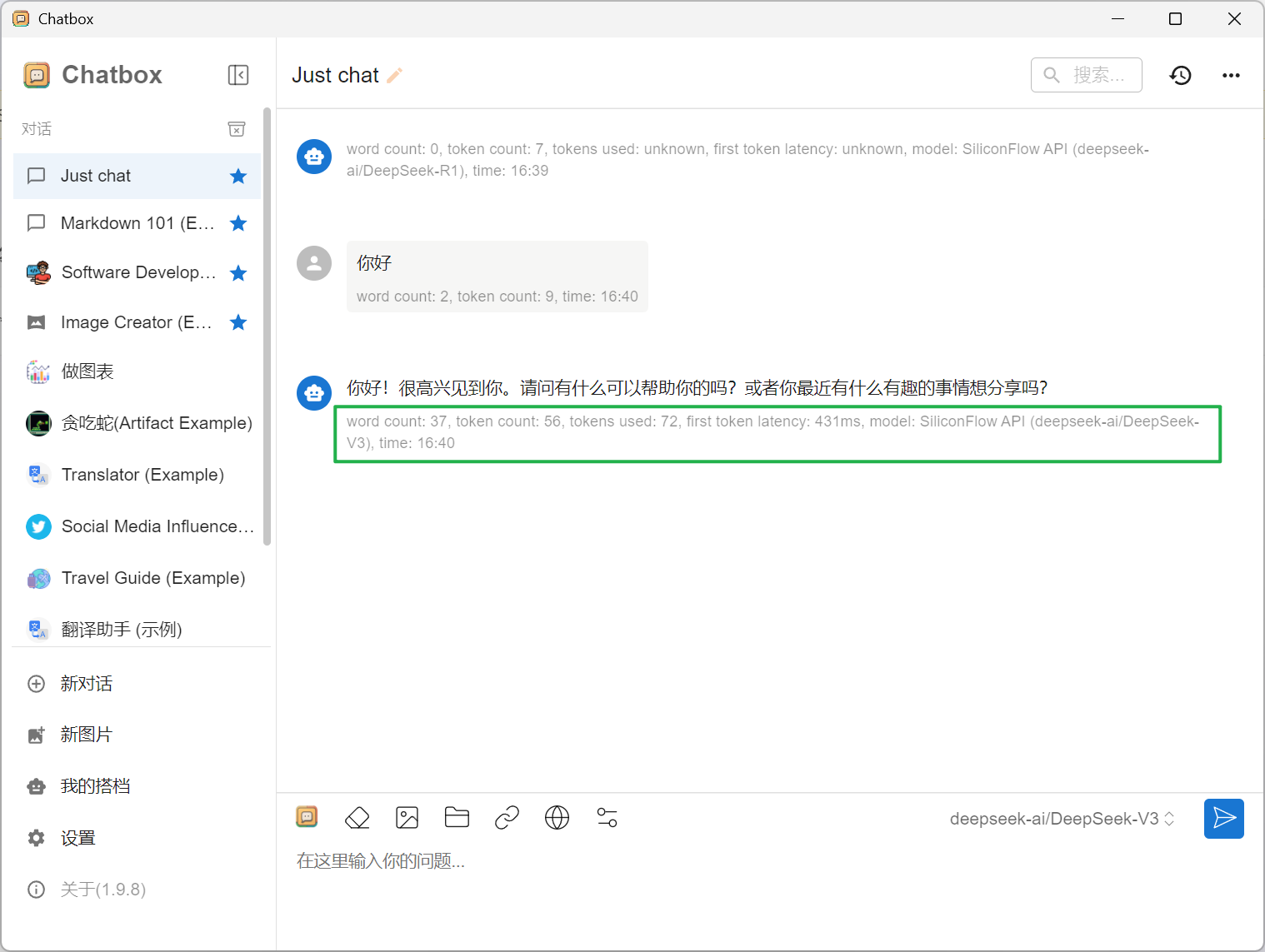

有了API密钥后就可以搞事情了~,比如做一个对话界面(ChatBox),就像是ChatGPT一样,进行日常使用,每次对话消耗的是你的的Tokens。也可以嵌入进IDE中等待一系列操作,具体可以网上百度,据说有很多人用这玩意儿已经开始发家致富了!动动脑子,你也可以的。

从上图可以看到刚刚的两组对话消耗Tokens所消耗的钱,新手机号注册是送14元体验金,使用完之后就是需要再次充值了,可以通过邀请新的手机号进行双方各得14元。再次贴上我的邀请码:3tdvbvxC,感谢各位。

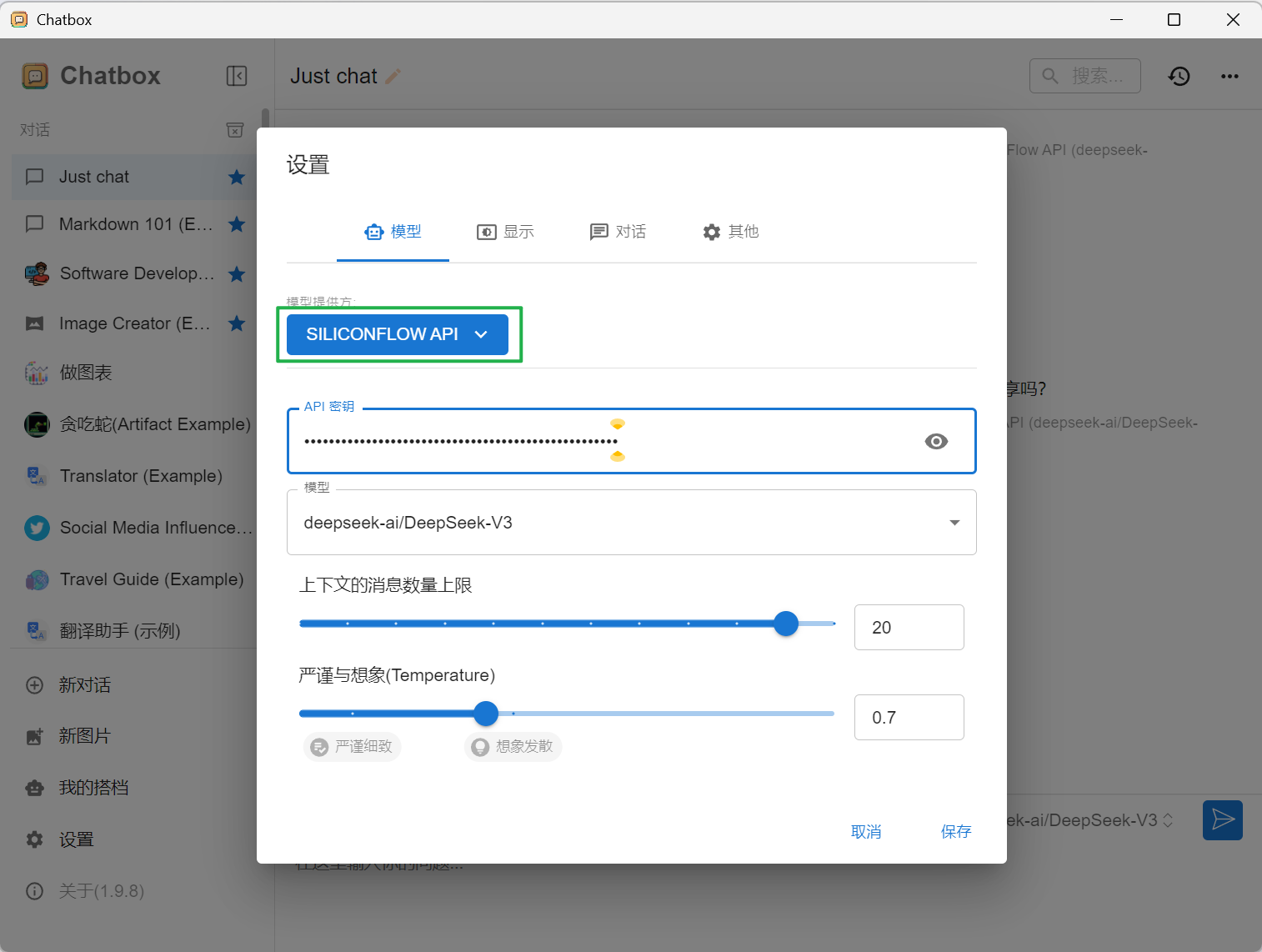

嵌入ChatBox¶

下载ChatBox:https://chatboxai.app/en

在设置中添加申请的API:

以V3模型为例:

Chatbox可以设置显示格式,比如上图所示显示消耗的tokens和总字数等。

Tip

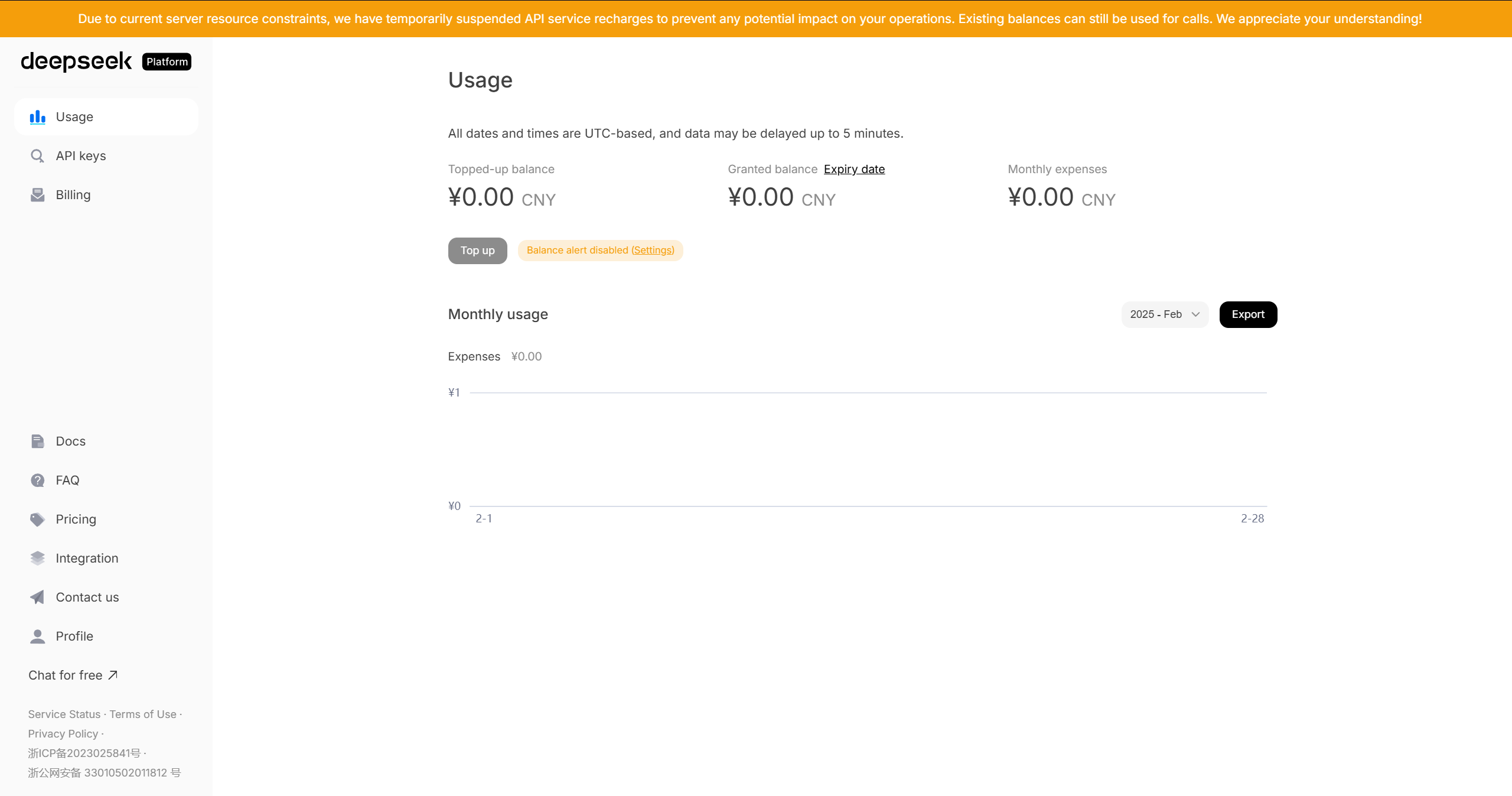

选择模型提供方时:—SiliconFlow API,而不是Deppseek,因为目前我们的API是在硅基流动平台申请的,如果选择Deppseek,就要去Deppseek后台去申请,目前官方已开放申请API功能,但是不能充值。

目前来说申请的API不支持联网搜索和上传图片。

基于deepseek搭建个人知识库¶

除了使用API嵌入自己的应用,还可以基于目前的大模型技术进行搭建属于自己的知识库,有点类似之前腾讯推出的“腾讯元宝”,可以吸收公众号的历史推文,做一个智能客服。本次案例将以 腾讯云平台 为例,将《有限元基础编程百科全书》纳入个人知识库中,使用deepseek R1进行调用翻阅。不能说很好用,算是对现如今的AI时代进行一个初步探索吧,紧跟时代潮流。

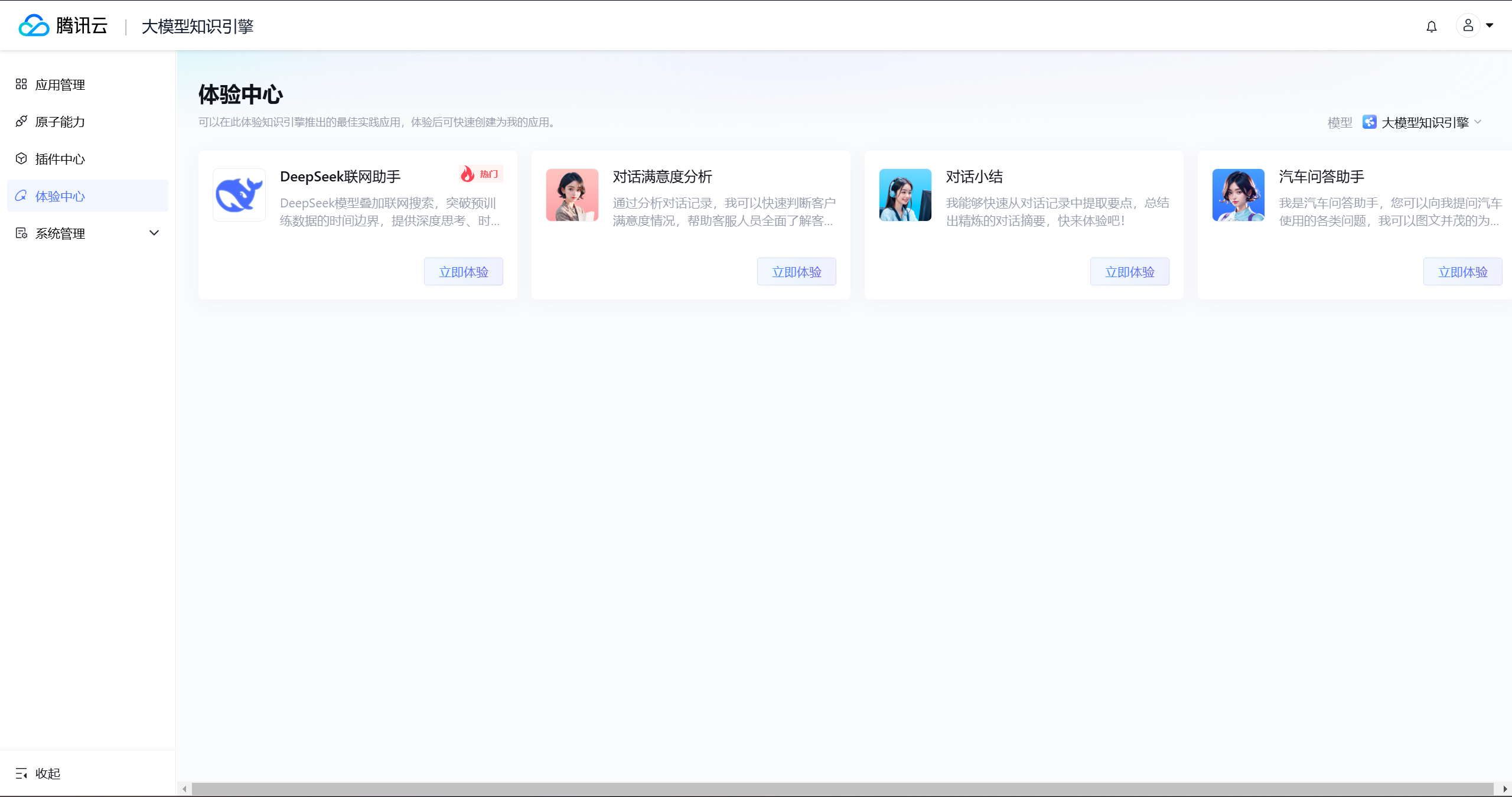

网址:https://lke.cloud.tencent.com/lke#/experience-center/home?origin=knowledge_engine

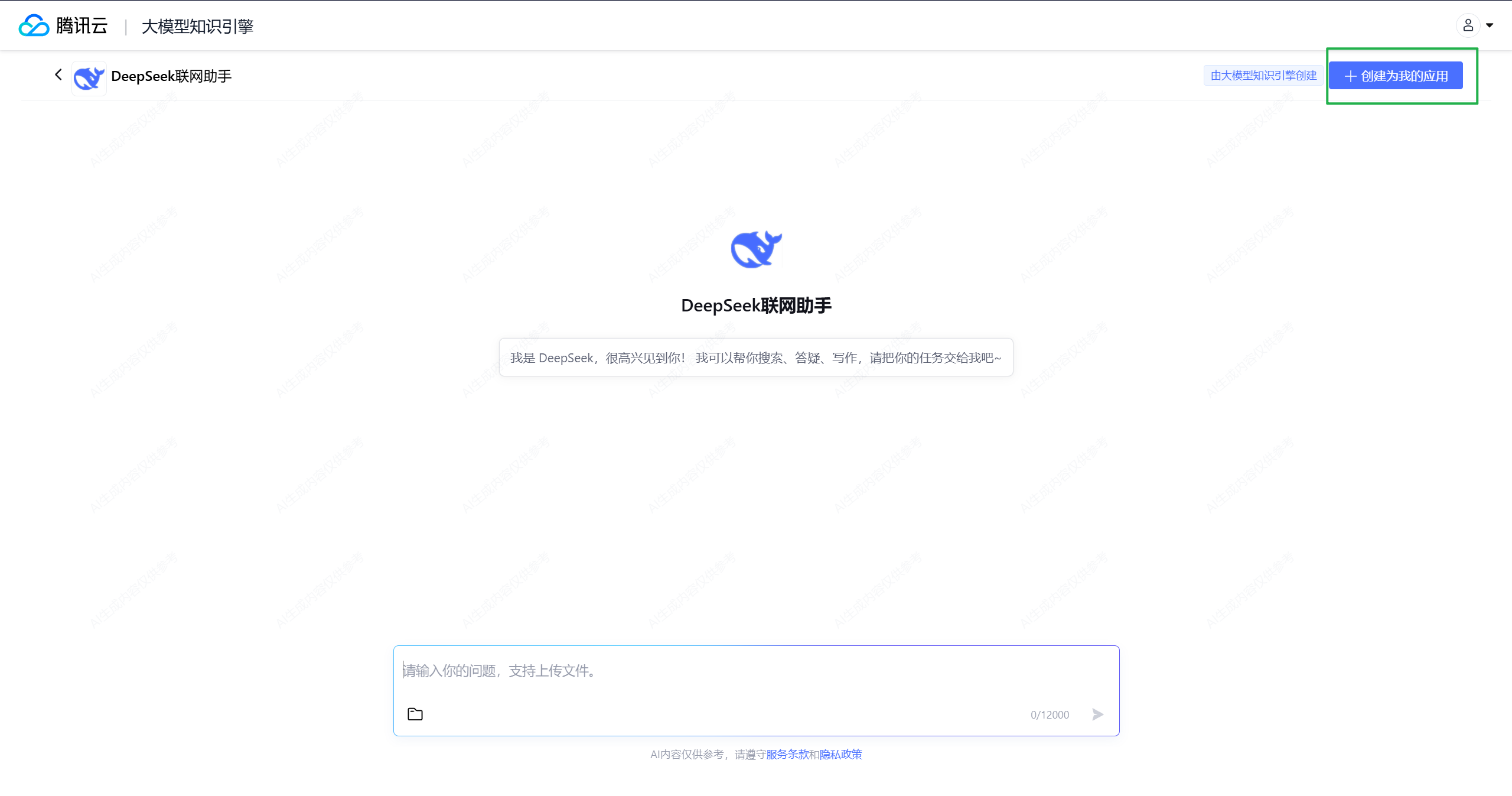

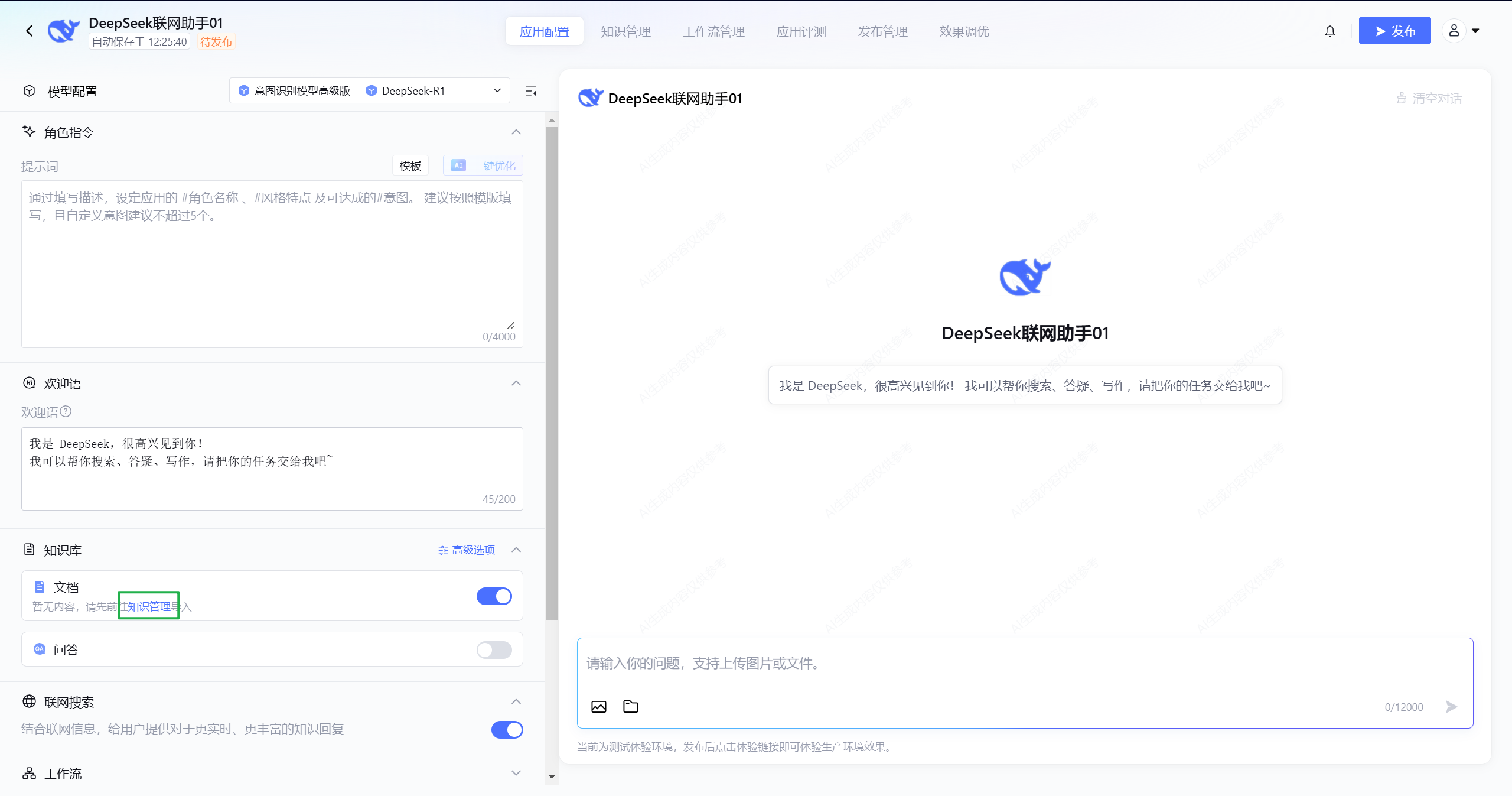

点击“联网助手”,顾名思义,这个模块下的大模型可以进行联网搜索,点击:创建我的应用。

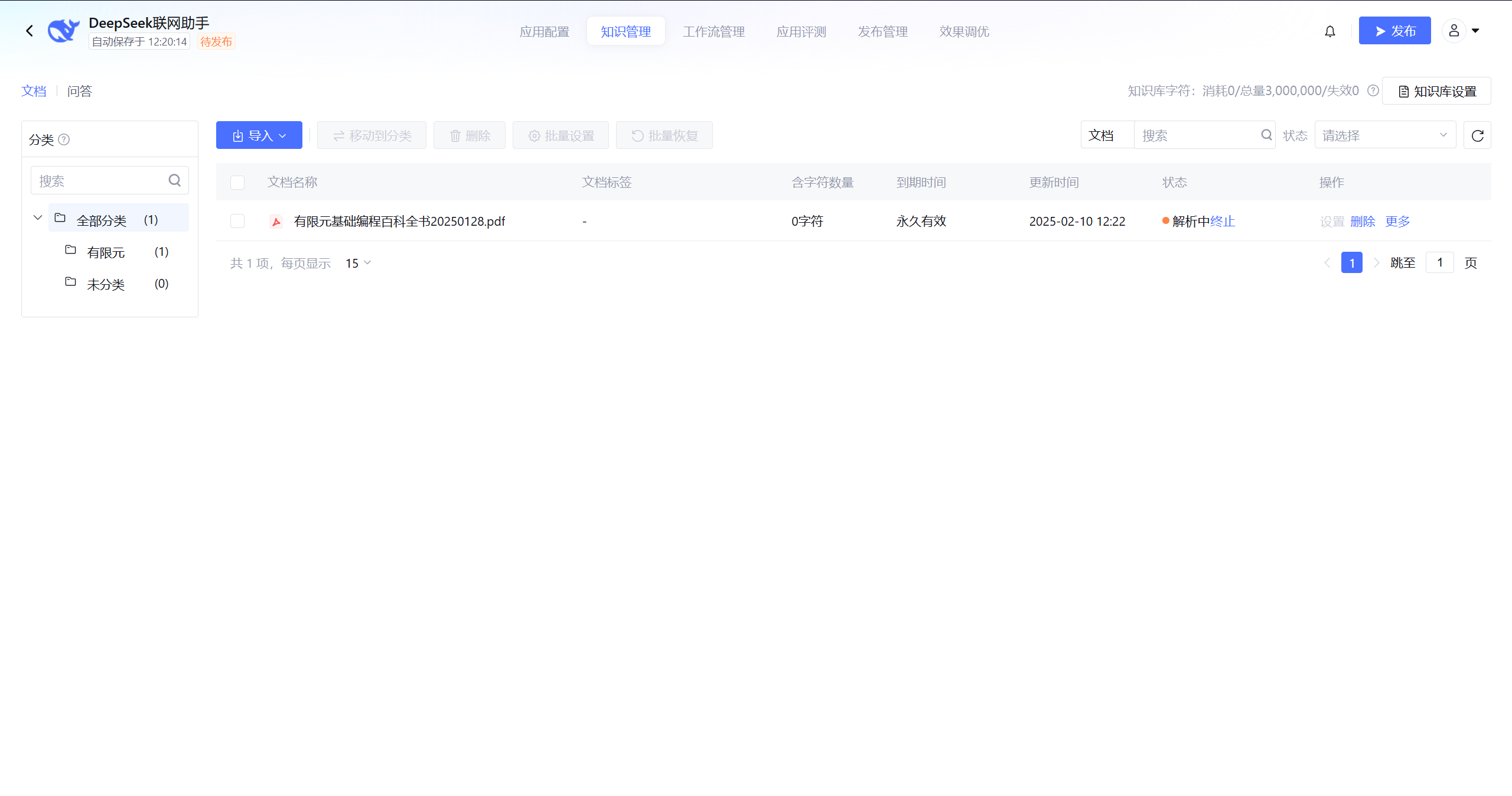

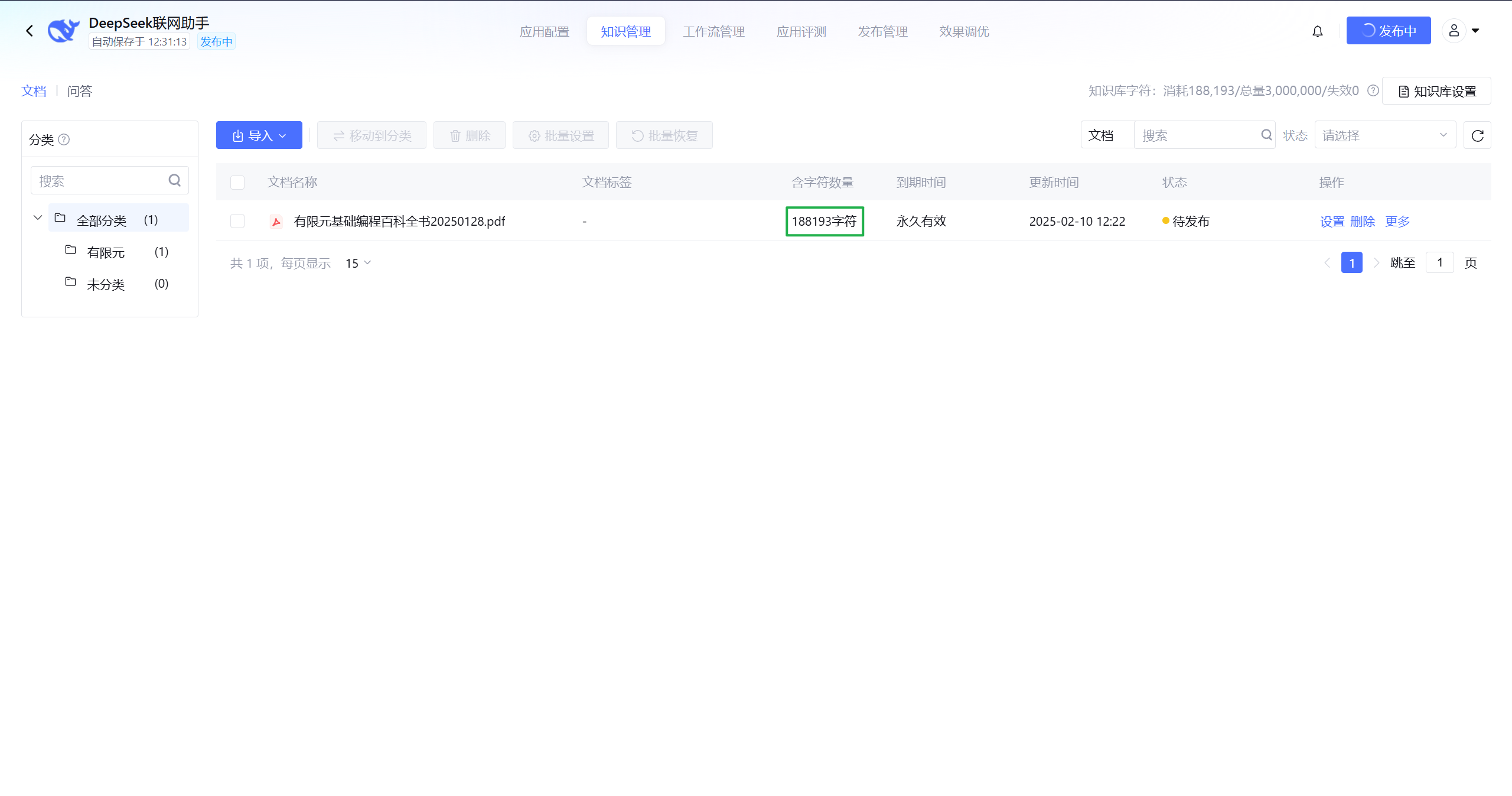

左侧有个知识库管理,将已经准备好的资料上传进入即可:

耐心等待一段时间,解析时间取决于资料的大小:

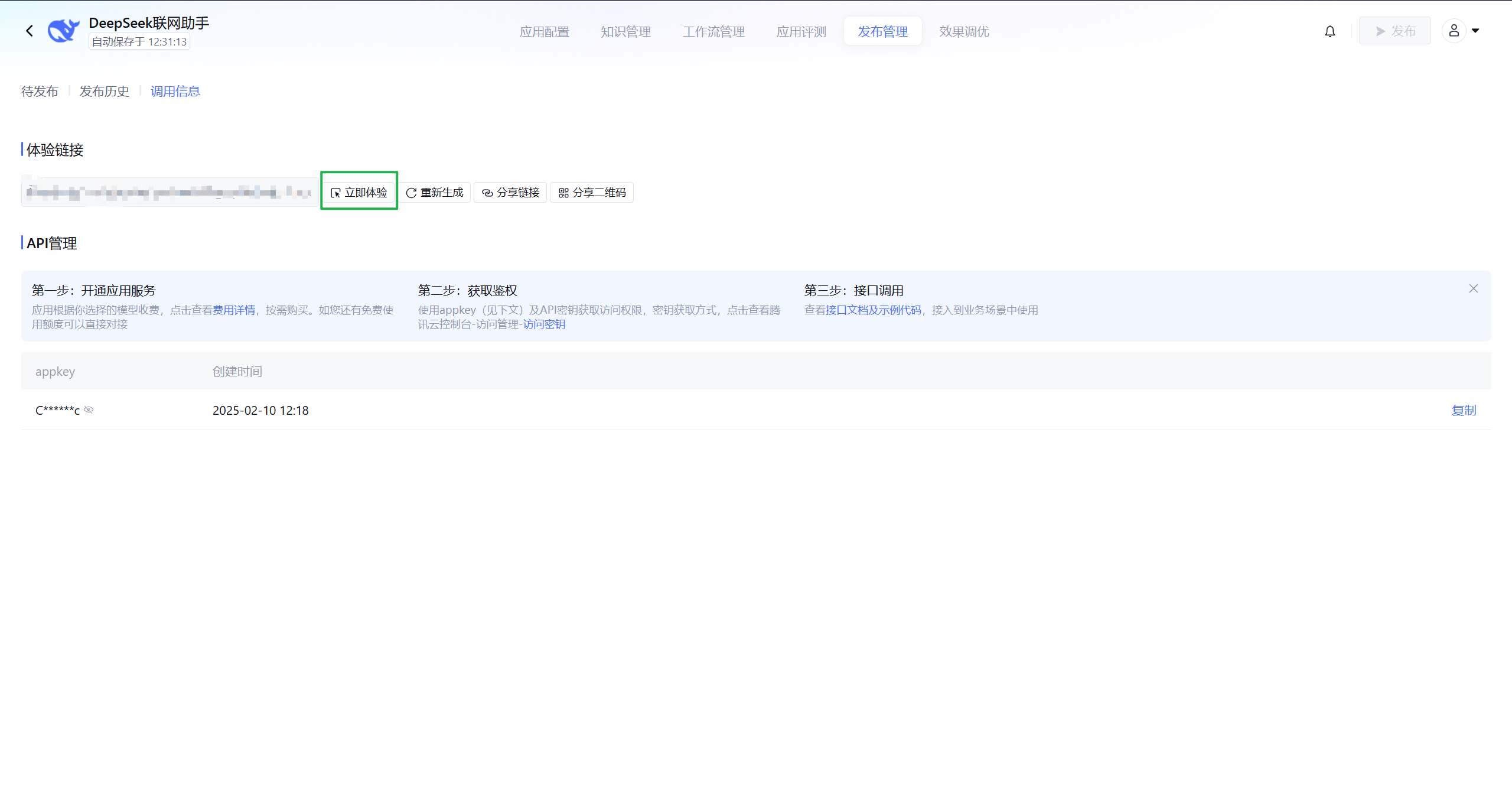

上传完成后进行发布,然后会给出体验链接,点击进入,即可与自己的知识库进行聊天:

比如提问:想要编写C3D8单元,该大模型会调用个人知识库,进行搜索相关知识:

在答案给出完毕,末尾会提供引用了知识库里面的哪些文件。点击即可链接到文件,仅限个人使用,若将链接分享给他人的话,他人也会获取到你知识库上传的资料,适合企业或团体协作办公情景。

现在测试一下联网搜索功能:

接入腾讯云deepseek API¶

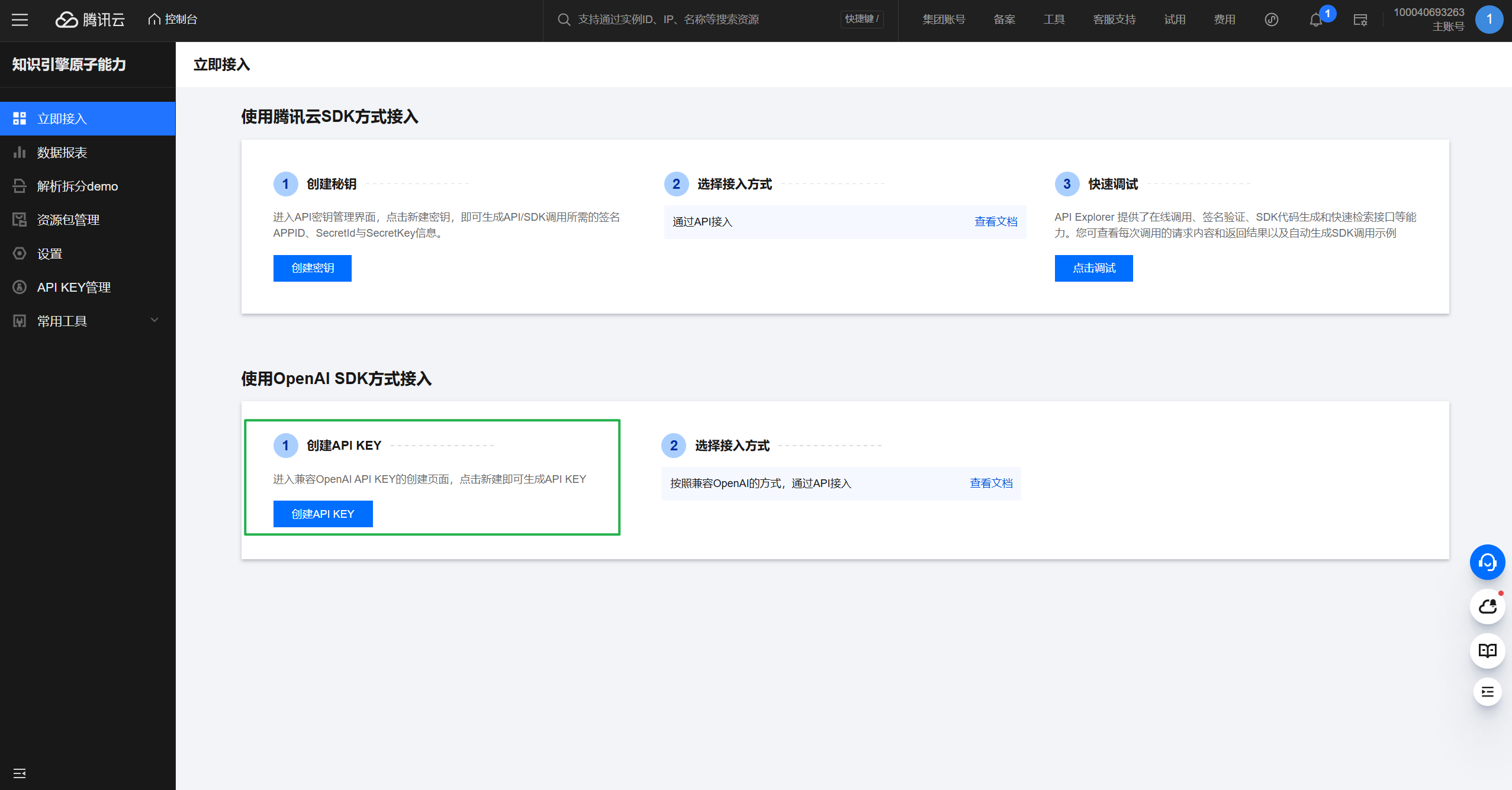

紧接着上节的操作,现在尝试调用腾讯云提供的deepseek API。目前腾讯云限时免费开放API,截止到2025年2月25日23:59:59,所有腾讯云用户均可享受DeepSeek-V3、DeepSeek-R1模型限时免费服务。申请入口:https://console.cloud.tencent.com/lkeap

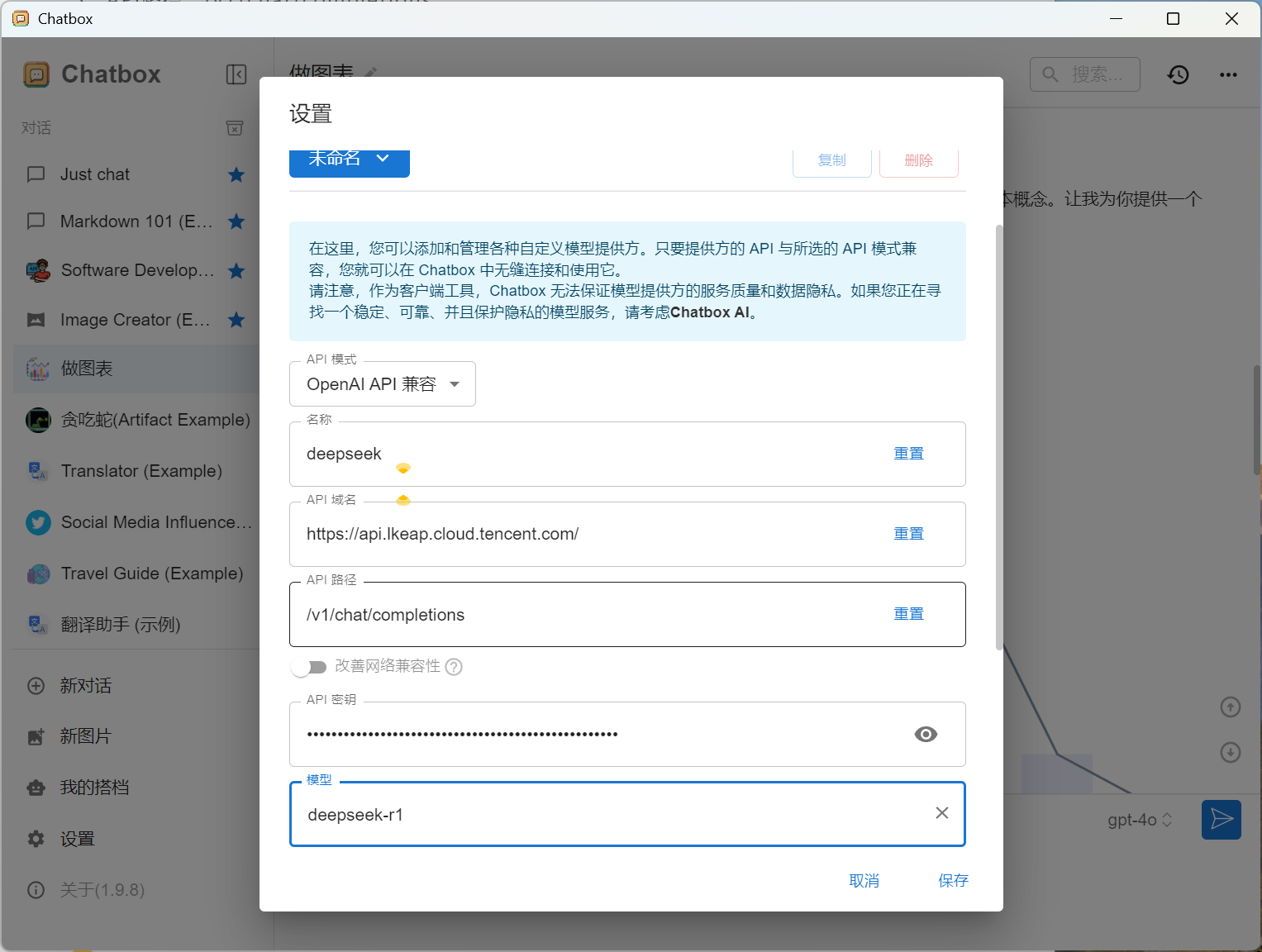

申请完毕后,还是以ChatBox为例,同样的操作,同样的配方,点击ChatBox设置:

- 模型提供方选择“添加自定义提供方”

- API模式选择“OpenAI API兼容”

- API域名:https://api.lkeap.cloud.tencent.com/

- API路径:/v1/chat/completions

- 密钥:刚刚申请时生成的API KEYS

- 模型名:deepseek-r1

然后就可以调用deepseek的API了,但是这样的调入方式目前尚且不能进行联网搜索。

本地模型添加联网搜索功能¶

本地模型有其独有的优势,隐私、反应快,不受网络环境影响,更不会受到什么宕机崩溃。但是缺点也是比较明显的,首先就是模型的性能取决于电脑的配置,配置高的电脑可以部署高级的模型,配置较低的电脑只能部署一些通用的模型,类似于GPT3.5;其次是没有联网搜索功能,这块就差点意思了~

本节主要分享如何在本地部署的基础上添加联网搜索功能,只能说过程极其简单!

在谷歌浏览器的插件商店下载:Page Assist(进入插件商店需要科学上网),保证Ollama的正常运行,一般根据之前本地部署教程进行操作后,Ollama是开机自启动的,目前来说不用管他。

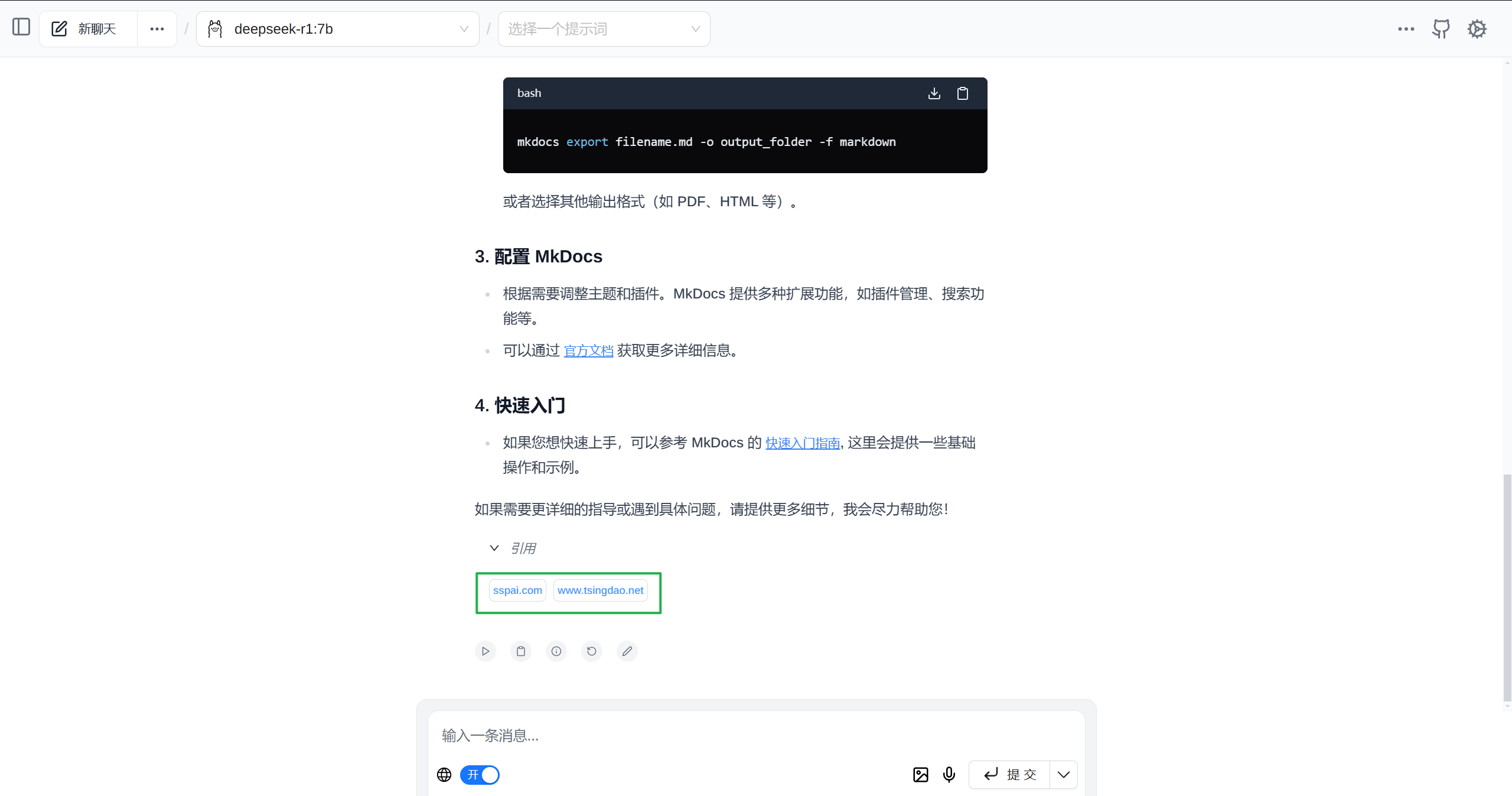

插件安装后,直接点击刚刚安装的Page Assist插件,就来到了大模型的页面,选择我们本地的模型版本,开启联网搜索功能:

就这样可以直接使用了,是不是超级简单~

个人网站添加deepseek智能聊天机器人¶

效果如下:

用户可以拖动聊天框在页面任何位置,在js文件中设置全局加载后,可以在网站中每个页面都可以加载聊天框,每次聊天需要调用deepssk的API,我在js中设置的是先前在硅基流动申请的deepseekAPI,具体的设置:

const API_KEY = " "; // 替换为您的 API 密钥

const API_URL = "https://api.siliconflow.cn/v1/chat/completions"; // 硅基流动平台的 API URL

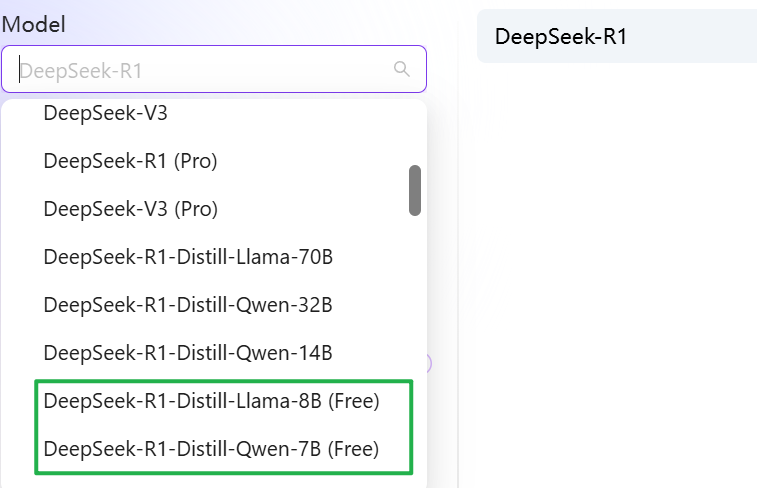

const MODEL_NAME = "deepseek-ai/DeepSeek-R1-Distill-Qwen-7B"; // 或 "deepseek-ai/DeepSeek-R1",根据您的需求选择

对于余额不足的用户可以使用免费的模型进行使用。